481 字

2 分钟

使用Ollama本地部署DeepSeek-R1大模型

环境准备与安装Ollama

Ollama支持macOS、Windows和Linux系统

-

下载安装 访问Ollama官方网站: https://ollama.com 点击Download按钮获取对应系统的安装包,双击完成安装。点击图标启动Ollama服务。

-

验证安装 打开终端,执行以下命令验证安装是否成功:

ollama --version

部署并运行DeepSeek-R1模型

-

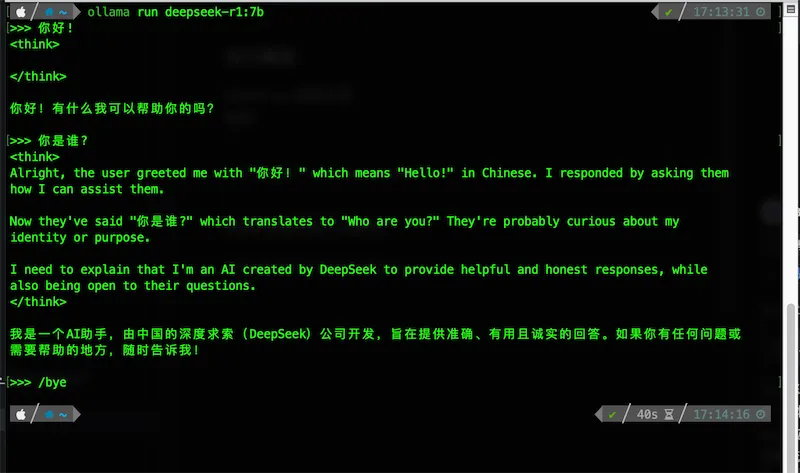

模型选择与拉取 执行以下命令自动下载并启动DeepSeek-R1模型:

ollama run deepseek-r1首次运行说明: 命令会自动从Ollama仓库拉取模型文件,请确保网络稳定。 如需指定版本,可使用带标签的命令:

ollama run deepseek-r1:latest -

模型仓库查询 访问Ollama模型库获取更多模型: https://ollama.com/search

-

运行效果

核心命令详解

| 命令用途 | 命令语法 | 示例 |

|---|---|---|

| 启动服务 | ollama serve | 后台启动Ollama服务 |

| 拉取模型 | ollama pull <模型名>:<版本> | ollama pull deepseek-r1:7b |

| 运行模型 | ollama run <模型名> | ollama run deepseek-r1 |

| 查看本地模型 | ollama list | 列出所有已下载的模型 |

| 查看模型详情 | ollama show <模型名> | ollama show deepseek-r1 |

| 删除模型 | ollama rm <模型名> | ollama rm deepseek-r1 |

| 模型参数调整 | ollama run <模型名> --<参数>=<值> | ollama run deepseek-r1 --temperature 0.7 |

实用技巧: 使用

ollama help <命令>获取具体命令的详细说明,如ollama help run。

交互式对话技巧

在模型运行界面,可使用以下特殊指令增强交互体验:

/? # 查看所有支持的交互指令/bye # 退出当前对话/show # 显示当前模型参数信息/set temperature 0.5 # 设置温度参数(0-1,值越高生成越随机)/clear # 清除对话历史上下文/load qwen # 不退出当前会话切换到qwen模型/save mychat # 将当前对话保存为mychat会话参数调优建议:

- 创意写作: temperature=0.7~0.9

- 事实问答: temperature=0.3~0.5

- 代码生成: top_k=50, temperature=0.4

使用Ollama本地部署DeepSeek-R1大模型

https://blog.dongge.de/posts/使用ollama本地部署deepseek-r1大模型/